Und die haben mittlerweile weitreichende Folgen. Personalentscheidungen, Kreditvergaben, medizinische Diagnosen: Seit über einem Jahrzehnt durchdringt die künstliche Intelligenz immer mehr Bereiche unseres Lebens. Auch die Juristin und Menschenrechtlerin Carina Zehetmaier beobachtet das. „Mir fehlte immer die Diversität im KI-Bereich, vor allem die Beteiligung von mehr Frauen“, sagt sie. Um das zu ändern, initiierte die Gründerin des KI-Start-ups Paiper.One 2019 erst eine Österreich-Sektion der mittlerweile mehr als 15.000 Mitglieder starken internationalen Initiative Women in AI. 2020 gründete sie dann mit 15 weiteren KI-Expertinnen den Verein Women in AI Austria. Das Ziel: Frauen zu ermächtigen, sich aktiv in KI-Debatten einzubringen – auch wenn sie beispielsweise keine Informatikerinnen sind.

Heute zählt Women in AI Austria rund 270 Mitglieder. „Wir möchten nicht nur Sichtbarkeit schaffen, sondern Frauen auch mit Wissen ausstatten und für das Thema begeistern“, erklärt Zehetmaier. Willkommen seien alle Gender. Wichtig sei die gemeinsame Mission, sich für mehr Vielfalt in der KI-Branche einzusetzen. Der Verein organisiert deshalb regelmäßig Vorträge, Podiumsdiskussionen, Hackathons und Netzwerktreffen, wie etwa monatliche Stammtische in Wien, die Expert:innen, Studierende und Interessierte zusammenbringen, um über aktuelle KI-Themen zu diskutieren.

und 2025 mit dem Award für die „Digitaler Humanismus

Persönlichkeit des Jahres“ ausgezeichnet. | © Markus Zahradnik

Eine Frage der Daten

Wenn von KI die Rede ist, geht es meist um maschinelles Lernen: Computersysteme erkennen Muster in großen Datenmengen und verbessern sich selbstständig, ohne explizit programmiert zu werden. Spamfilter, Spracherkennung oder Chatbots wie ChatGPT sind bekannte Beispiele. Doch diese Systeme lernen aus bereits bestehenden Daten – und diese sind oft voller gesellschaftlicher Vorurteile. „KI lernt aus Daten der Vergangenheit – und die sind nicht immer divers“, warnt Zehetmaier.

So zeigt sich etwa in der Medizin, dass KI-Systeme oft weniger präzise Diagnosen für Frauen stellen, weil sie überwiegend mit Daten von männlichen Patienten trainiert wurden. Einige Kreditvergabe-Systeme in den USA benachteiligten Frauen, People of Color sowie Menschen mit lateinamerikanischer Migrationsgeschichte, da sie auf Basis historischer Daten Ergebnisse errechneten. Früher hatten diese Gruppen allerdings kaum Zugang zu Krediten und waren in den unteren Einkommensklassen überrepräsentiert. Die KI ging deshalb davon aus, sie wären weniger kreditwürdig.

Die Diskriminierungsfrage spielt auch im Personalbereich eine große Rolle. Der Onlinehändler Amazon testete zwischen 2014 und 2017 ein KI-gestütztes Bewerber:innen-System, um Einstellungsprozesse zu automatisieren. Das Programm wurde mit Lebensläufen der vergangenen zehn Jahre trainiert – in denen die Tech-Branche stark von Männern dominiert war. Das Ergebnis: Die KI bevorzugte männliche Bewerber. 2018 wurde das Projekt eingestellt, da die Verzerrungen nicht behoben werden konnten.

Eine schwedische Untersuchung aus dem Vorjahr zeigte, dass dortige KI-Systeme in Vorstellungsgesprächen die Antworten von Männern – insbesondere von jenen mit angelsächsischem Namen – gegenüber anderen Kandidat:innen schlechter bewerteten. Studienautorin Celeste de Nadai vermutet, dass diese Verzerrung eine Überkorrektur früherer KI-Verzerrungen darstellen könnte, die Männer und westliche Namen noch bevorzugten.

Einzementierte Rollen

Ein Experiment der deutschen NGO AlgorithmWatch aus dem Jahr 2020 verdeutlicht, wie Geschlechterrollen in Algorithmen zementiert werden: Die Organisation schaltete auf Facebook verschiedene Jobanzeigen, ohne zu spezifizieren, welcher Zielgruppe diese angezeigt werden sollten. Die Social-Media-Plattform zeigte daraufhin eine Anzeige für Lkw-Fahrer:innen überwiegend Männern, während eine Anzeige für Kinderbetreuer:innen fast nur Frauen ausgespielt wurde. Das zeigt, dass KI oft nicht dazu beiträgt, Stereotype aufzubrechen – sondern sie spiegelt und damit verstärkt.

Auch die Gestaltung technischer Geräte trägt dazu bei. Sprachassistenten wie Siri oder Alexa sind standardmäßig mit weiblichen Stimmen programmiert. Das festigt das Bild von Frauen in unterwürfigen, dienenden Rollen, wie ein UNESCO-Bericht bereits 2019 unterstrich. Als besonders problematisch erwies sich in der Vergangenheit, dass die Assistenten auf verbale Belästigung ausweichend oder sogar mit flirtähnlichen Antworten reagieren.

Die größte Hürde ist oft, ein Tool zum ersten Mal zu nutzen.

Aber sobald diese Schwelle überschritten ist, ändert sich vieles.

Carina Zehetmaier

Studien zeigen außerdem, dass manche Gesichtserkennungssoftwares weiße, männliche Gesichter besser erkennen als die von Frauen oder People of Color. Auch für LGBTIQA+-Personen bergen die modernen Technologien Risiken: Algorithmen, die Social-Media-Profile analysieren, könnten in repressiven Ländern dazu führen, dass queere Menschen ungewollt geoutet oder diskriminiert werden. Manche Systeme kennen auch nur zwei Gender-Kategorien und stufen nichtbinäre oder Transpersonen falsch ein oder machen sie unsichtbar. Eine Transgender-Person in Russland hatte Schwierigkeiten, sich bei der KI-gesteuerten Stimmerkennung ihrer Bank zu authentifizieren – die androgyne Stimme passte nicht in das binäre Raster des Systems.

Arbeitsmarkt: Wer verliert?

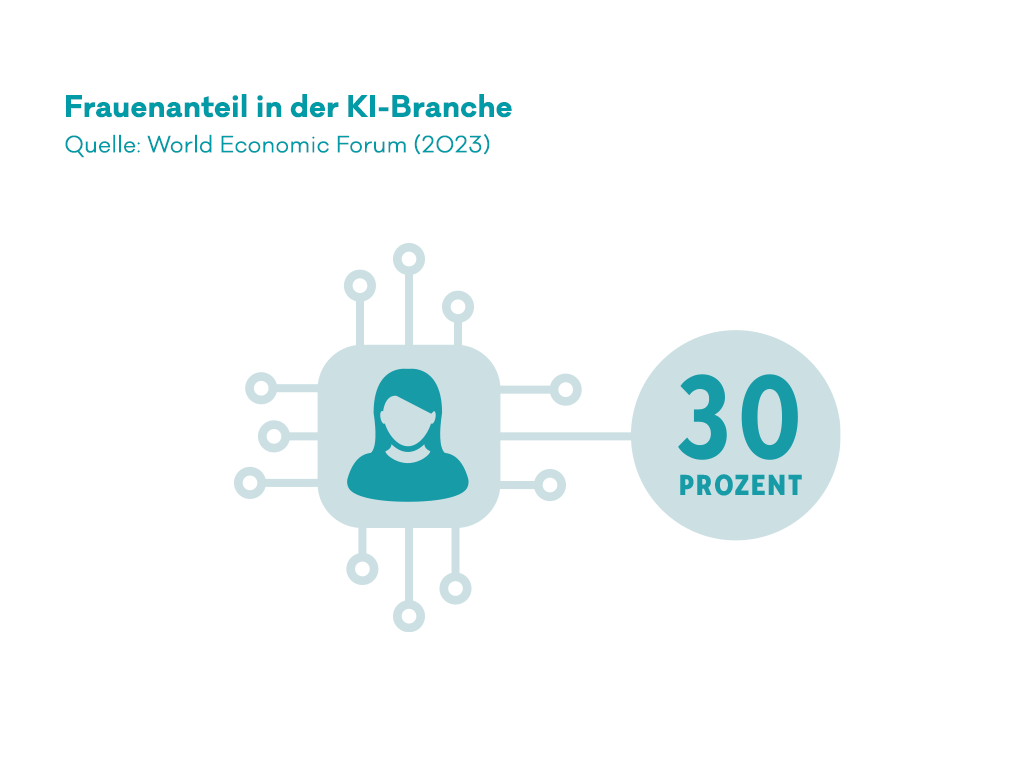

Technologische Innovationen – und hier insbesondere die KI – verändern gerade den gesamten Arbeitsmarkt. Viele Jobs werden sich wandeln, einige sogar ganz verschwinden. Laut der Internationalen Arbeitsorganisation (ILO) sind insbesondere Routinetätigkeiten betroffen – etwa Schreibarbeiten, Buchhaltung oder Dateneingabe. Da diese Berufe überdurchschnittlich häufig von Frauen ausgeübt werden, sind sie besonders vom Jobverlust bedroht.

Zudem nutzen Frauen generative KI-Systeme wie ChatGPT laut Studien um fast ein Drittel seltener als Männer. „Das hat auch mit der Sozialisierung zu tun“, meint Zehetmaier. Gleichzeitig würden sich Frauen oft nicht von den neuesten technischen Tools und auch nicht von technischen Studiengängen angesprochen fühlen. Doch wer nicht lernt, die Tools zu bedienen, wird im Beruf an Wettbewerbsfähigkeit verlieren.

Darf der Arbeitgeber die Nutzung von KI verbieten? Oder sogar darauf bestehen? Wir beantworten die wichtigsten Fragen dazu:

Was also tun? Zehetmaier, die auch Mitglied des KI-Beirats der österreichischen Bundesregierung sowie Vorsitzende der Arbeitsgruppe Künstliche Intelligenz der Austrian Standards ist, sieht mehrere Ansätze: Die Trainingsdaten von KI-Systemen und die Entwicklungsteams müssten diverser werden, damit sie alle gesellschaftlichen Gruppen bestmöglich repräsentieren. Gleichzeitig brauche es mehr Transparenz, damit Entscheidungen überprüfbar bleiben. Und nicht zuletzt seien gesetzliche Regulierungen nötig, um ethische Standards sicherzustellen.

Doch es reicht nicht, nur an der Technik und an Gesetzen zu schrauben: Auch das gesellschaftliche Mindset muss sich ändern. „Wir müssen Mädchen und junge Frauen früh für Technik begeistern“, sagt Zehetmaier. Bildungsprogramme, die Frauen und Minderheiten in der KI-Branche fördern, seien essenziell. „Die größte Hürde ist oft, ein Tool zum ersten Mal zu nutzen. Aber sobald diese Schwelle überschritten ist, ändert sich vieles.“ Zehetmaier und Women in AI Austria würden weiter daran arbeiten, aufzuklären und Veränderungen anzustoßen. Denn KI betrifft uns alle – und je mehr diverse Stimmen in ihrer Entwicklung mitentscheiden, desto gerechter werden die Systeme der Zukunft.